Il est sûr cetteaction ne peut pas être annulée

Semi-Conducteurs

L’histoire du transistor est une saga fascinante qui s’étend sur des décennies d’efforts scientifiques et de progrès technologiques. Tout a commencé en 1926 lorsque Julius Edgar Lilienfeld, un physicien austro-hongrois-américain, a breveté un dispositif qui allait jeter les bases de ce qui serait plus tard connu sous le nom de transistor. Lilienfeld a imaginé un dispositif à effet de champ avec une électrode métallique séparée d'un semi-conducteur par une fine couche d'oxyde.

Cependant, malgré sa vision pionnière, les limitations technologiques de l’époque ont empêché la réalisation pratique de son invention. L'idée a été oubliée pendant des décennies.

Ce n’est que dans les années 1940 que les progrès dans la compréhension des semi-conducteurs et le besoin croissant de dispositifs de commutation et d’amplification en électronique ont suscité un regain d’intérêt pour la recherche sur les dispositifs à semi-conducteurs.

En 1947, aux Laboratoires Bell, situés aux États-Unis, la percée a eu lieu. John Bardeen, Walter Brattain et William Shockley, travaillant en équipe, ont développé le premier transistor bipolaire fonctionnel. Ce dispositif consistait en un semi-conducteur en germanium avec des électrodes connectées à chaque extrémité. Grâce aux courants de base, ils ont réussi à contrôler le flux de courant entre l’émetteur et le collecteur, ce qui a permis d’amplifier les signaux électriques. Cette étape marquante a marqué le début de l’ère des transistors.

L'invention du transistor bipolaire également appelé BJT « Bipolar Junction Transistor » a révolutionné l'industrie électronique, offrant un remplacement plus efficace et plus compact aux tubes à vide utilisés jusqu'alors. Des radios portables aux ordinateurs, les transistors sont devenus les éléments fondamentaux de l’électronique moderne.

Cependant, la recherche d’appareils plus efficaces et plus polyvalents s’est poursuivie. Dans les années 1950, Mohamed Atalla et Dawon Kahng, travaillant aux Bell Labs, ont développé le transistor à effet de champ métal-oxyde-semiconducteur (MOSFET), basé sur le concept initial de Lilienfeld. Cet appareil présentait une structure plus simple et offrait de meilleures caractéristiques de commutation et une meilleure efficacité énergétique.

Le MOSFET, breveté en 1959, est devenu la pierre angulaire de l'industrie des semi-conducteurs, favorisant les progrès dans les domaines de l'électronique grand public, des télécommunications et de l'informatique. Son design raffiné et sa capacité à s'intégrer dans des circuits intégrés en ont fait la pièce maîtresse de la révolution numérique.

Depuis ses modestes débuts dans les années 1920 jusqu’à son évolution vers le transistor MOSFET, l’histoire du transistor témoigne du pouvoir de la recherche scientifique et de l’innovation technologique pour transformer le monde sans jamais s’arrêter. Dans les années 1980, le transistor IGBT a été inventé. Ce transistor est considéré comme un hybride entre le transistor bipolaire et le MOSFET. Dans ce cas nous avons préféré placer les transistors IGBT en dehors de cette section et ils ont leur propre section.

Les principales différences entre les quatre types de transistors sont :

Les transistors bipolaires, FET, MOSFET et IGBT ont joué un rôle fondamental dans le développement de l'électronique moderne. Ils sont utilisés dans une large gamme d'appareils, des radios aux téléphones portables.

Les quatre types de transistors ont subi une évolution significative depuis leur invention. Les principales améliorations ont porté sur :

L'explication du fonctionnement d'un transistor bipolaire est très détaillée. Les lignes qui suivent expriment de manière très, très abrégée cette opération.

Tout d’abord, il est nécessaire d’introduire quelques concepts physiques du transistor et pour ce faire nous commenterons brièvement sa structure semi-conductrice.

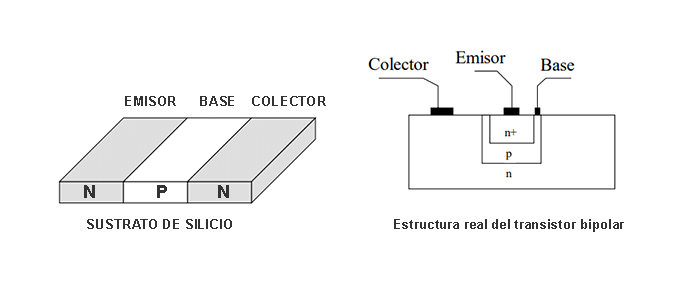

Le transistor bipolaire est constitué d'un dispositif composé de trois régions semi-conductrices séparées par des jonctions PN. Dans la figure immédiatement ci-dessous, et à gauche, une représentation utile pour analyser le transistor bipolaire est présentée. Il est indispensable que le dopage des régions soit alterné ; Autrement dit, si l'émetteur est de type P, alors la base sera de type N et le collecteur sera de type P, ce qui donnera un transistor bipolaire de type PNP. En revanche, si l'émetteur est de type N, alors la base sera de type P et le collecteur sera de type N, créant un transistor bipolaire de type NPN.

La fabrication du transistor est réalisée sur un substrat de silicium, dans lequel des impuretés diffusent pour obtenir les trois régions évoquées ci-dessus. La figure ci-dessus et à droite montre l'apparence typique d'un véritable transistor bipolaire que l'on trouve dans n'importe quel circuit intégré. Sur une base de type n (agissant comme un collecteur), sont diffusées les régions p et n+, dans lesquelles sont placés les contacts de l'émetteur et de la base.

L'émetteur doit être fortement dopé (noté p+). Plus le dopage de l’émetteur est élevé, plus il peut apporter de porteurs de charge au courant.

La base doit être étroite et légèrement dopée pour minimiser la recombinaison dans celle-ci, permettant ainsi à la majeure partie du courant de l'émetteur de passer vers le collecteur, comme nous le verrons plus tard. Si la base n'est pas assez étroite, le dispositif risque de ne pas fonctionner comme un transistor et de se comporter plutôt comme deux diodes en opposition.

Le collecteur doit être une région moins dopée que l'émetteur, et ses caractéristiques sont liées à la recombinaison des porteurs issus de l'émetteur.

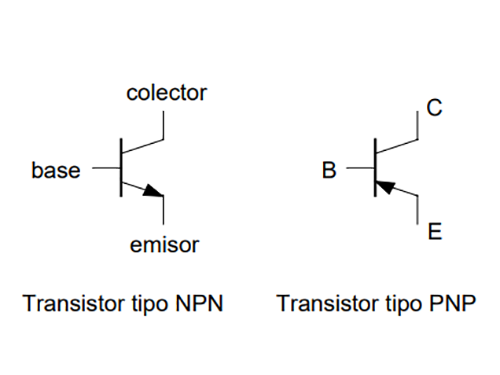

Comme nous l'avons vu précédemment, le transistor bipolaire est constitué de trois bornes : l'émetteur, le collecteur et la base. Selon sa construction, il peut être classé en deux types : NPN et PNP. Celui du bas montre les symboles des circuits et la nomenclature de leurs bornes. Pour faire la distinction entre un transistor NPN et un transistor PNP, regardez le sens de la flèche sur la borne de l'émetteur : sur un NPN, la flèche pointe vers l'opposé du transistor, tandis que sur un PNP, la flèche pointe vers l'intérieur. De plus, dans des conditions normales de fonctionnement, la flèche indique le sens du courant circulant dans l'émetteur du transistor.

En règle générale, certaines tensions et courants sont définis aux bornes du transistor, comme illustré dans les deux figures ci-dessous. Ces définitions sont celles qui seront utilisées dans ces lignes et en suivent une représentation physique, puisque dans des conditions normales de fonctionnement, tous les courants et tensions définis sont positifs. Bien qu’il existe d’autres moyens d’indiquer ces tensions et courants, ils ne seront pas abordés dans cette section.

Les zones de fonctionnement d'un transistor bipolaire sont étroitement liées à sa polarisation. La polarisation d'un transistor fait référence à l'application de tensions ou de courants à ses bornes pour établir les conditions de fonctionnement souhaitées. Selon la façon dont le transistor est polarisé, il peut fonctionner dans différentes régions qui déterminent son comportement et ses caractéristiques de sortie. Les principaux domaines d’intervention sont :

Ces zones de fonctionnement sont étroitement liées à la polarisation des transistors, qui peut être obtenue grâce à des configurations de circuits spécifiques. Par exemple, dans une polarisation de diviseur de tension, des résistances sont utilisées pour appliquer des tensions spécifiques à la base et à l'émetteur, ce qui place le transistor dans la région active. En pratique, les circuits de polarisation sont conçus pour garantir que le transistor fonctionne comme souhaité, soit comme amplificateur linéaire dans la région active, soit comme commutateur dans la région saturée, selon l'application spécifique.

La polarisation du transistor consiste à fixer son point de travail dans une zone de travail en l'absence de signal d'entrée. Nous appelons cette zone de travail le point Q. Généralement, ce point est situé dans la région active du transistor, où les signaux peuvent être amplifiés de manière linéaire et stable. Cependant, il est possible que le point Q se trouve dans les zones de coupure et de saturation dans des circonstances spécifiques, bien que cela ne soit pas souhaitable dans la plupart des applications.

Le point Q est défini par les tensions et les courants aux bornes du transistor lorsqu'il est polarisé dans un circuit spécifique. La polarisation fait référence à l'application de tensions ou de courants aux bornes du transistor pour établir son point de fonctionnement souhaité.

Dans un transistor bipolaire, la polarisation est réalisée par des circuits spécialement conçus pour régler le point Q à un niveau optimal. Cela garantit que le transistor fonctionne de manière stable et linéaire dans la région active, où il peut amplifier efficacement le signal d'entrée.

Le choix de la polarisation appropriée dépend de plusieurs facteurs, tels que la linéarité souhaitée, la stabilité thermique et les exigences d'efficacité de l'amplificateur. Les circuits de polarisation, tels que la polarisation du diviseur de tension ou la polarisation de l'émetteur commun, sont conçus pour définir le point Q de manière optimale, en tenant compte des spécifications du transistor et des besoins du circuit.

La température influence également le point Q et donc les performances du transistor. À mesure que la température change, les caractéristiques électriques du transistor, telles que le gain de courant β et le courant de saturation inverse IS, peuvent varier.

Ces modifications des caractéristiques du transistor peuvent affecter le point Q et donc le comportement du circuit dans lequel il est intégré. Par exemple, une augmentation de la température peut entraîner une augmentation du courant de saturation inverse, ce qui peut déplacer le point Q et affecter la stabilité du circuit.

Pour compenser les effets de la température, des techniques de compensation thermique sont souvent utilisées dans la conception des circuits. Cela peut impliquer l'utilisation de composants présentant des coefficients de température complémentaires ou la conception de circuits minimisant les effets des variations de température au point Q.

En résumé, le point Q est étroitement lié à la polarisation et à la température du transistor. L'établissement d'un point Q approprié est essentiel pour garantir un fonctionnement optimal et stable du transistor dans un circuit électronique, en particulier dans des conditions de température variables.

Le fonctionnement du transistor bipolaire peut être expliqué à l'aide de l'équation d'Ebers-Moll, qui décrit les courants des porteurs de charge (électrons et trous) dans un transistor bipolaire. L'équation d'Ebers-Moll est une description simplifiée du comportement des transistors et est basée sur la théorie du transport de charge dans les semi-conducteurs.

L'équation d'Ebers-Moll pour un transistor bipolaire de type NPN est :

| Ic=IS * (eVBE/VT -1) - αR IS * (eVBC/VT -1) |

| IE = ßF IC + ßR IB |

Où:

| Ic | est le courant du collecteur |

| IE | est le courant de l'émetteur |

| IB | est le courant de base |

| VBE | est la tension entre la base et l'émetteur |

| VBC | est la tension entre la base et le collecteur |

| IS | est le courant de saturation inverse de l'émetteur |

| VT | est la tension thermique |

| βF y βR | ce sont respectivement les gains de courant direct et inverse |

| αR | est le gain de courant inverse |

La tension thermique VT serait définie par K*T/q ; où K est la constante de Boltzmann, T est la température en degrés Kelvin et q est la charge de l'électron. Il s’agit donc d’une constante liée à la température absolue du semi-conducteur et à la charge de l’électron. Sa valeur est généralement d'environ 25 ou 26 mV à température ambiante (environ 300 ° Kelvin. Elle est également connue sous le nom de tension de jonction base-émetteur dans les transistors bipolaires.

La tension thermique est essentielle pour décrire le comportement du transistor. C'est une grandeur essentiellement liée à l'énergie thermique des porteurs de charge (électrons et trous) dans le semi-conducteur. Plus la température est élevée, plus l'énergie thermique des porteurs de charge est importante et donc plus la tension thermique est élevée.

Dans l'équation d'Ebers-Moll, le terme de tension thermique, VT, apparaît dans l'exposant de la fonction exponentielle qui décrit la relation entre la tension VBE et le courant du collecteur Ic. Ce terme reflète la manière dont le flux de porteurs de charge entre la base et l'émetteur varie en fonction de la température. En résumé, la tension thermique définit la sensibilité du transistor aux changements de température et affecte directement son comportement et ses caractéristiques de fonctionnement.

À température ambiante, l'équation d'Ebers-Moll peut être simplifiée par plusieurs approximations. La plus courante est l’hypothèse selon laquelle le terme exponentiel eVBC/VT est approximativement égal à e0 car VBE est relativement petit par rapport à VT. Ceci est valable dans la plupart des cas typiques de fonctionnement d'un transistor bipolaire à température ambiante.

Par conséquent, à température ambiante, l’équation d’Ebers-Moll peut être simplifiée comme suit :

Ic∼IS (e0 -1) - αR IS * (eVBC/VT -1)

Ic∼ - αR IS * (eVBC/VT -1)

Cette simplification est couramment utilisée dans l'analyse de circuits et la conception de transistors bipolaires à température ambiante, où VBE est beaucoup plus petit que VT. Cependant, il est important de rappeler que cette simplification est une approximation et peut ne pas être valable dans tous les cas, notamment dans les applications où une grande précision est requise.

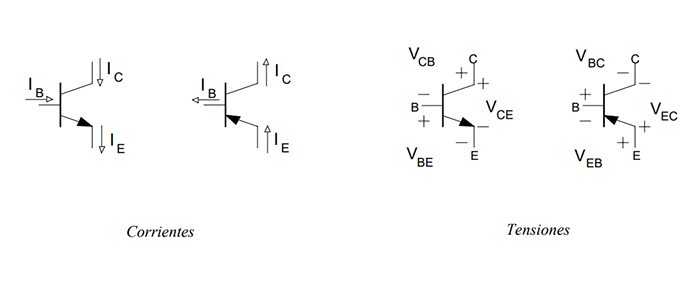

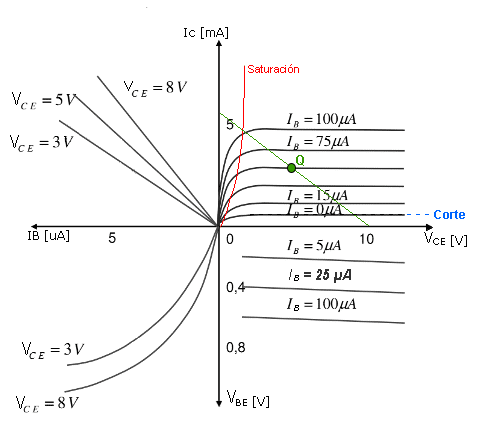

Le graphique d'un transistor bipolaire est présenté dans l'image ci-dessous.

Le courant du collecteur dépend du courant de base, qui à son tour dépend de la tension base-émetteur. Nous avons deux zones frontalières. D'une part, dans la zone inférieure et avec des lignes bleues, nous avons marqué la zone de coupure, où le courant du collecteur prend une très petite valeur, proche de l'ICO. Une fois la tension de seuil dépassée, le courant de base croît de façon exponentielle avec la tension bae-émetteur, obtenant des valeurs élevées dans le courant du collecteur, jusqu'à atteindre la saturation du transistor. Cette tension de seuil dans un transistor au silicium est de l'ordre de 0,5V. A partir de 0,7V on serait déjà en zone active, mais en arrivant vers 0,8V on serait déjà en saturation.

Comme nous l'avons dit précédemment, le point Q doit être placé dans la zone active en l'absence de signal. Dans la figure ci-dessous, nous avons la même courbe précédente, où nous avons déjà représenté le point de travail (Q). La ligne verte représente la ligne de chargement. qui dépend de la polarisation du transistor (en absence de signal). Si Q est très proche de l'axe des ordonnées, cela signifie qu'il est proche de la région de saturation, tandis que si Q est très proche de l'axe des abscisses, cela signifie qu'il est proche de la région de coupure. En fonction du courant de base, le transistor se trouve à un point de fonctionnement ou à un autre, le long de la ligne de charge.

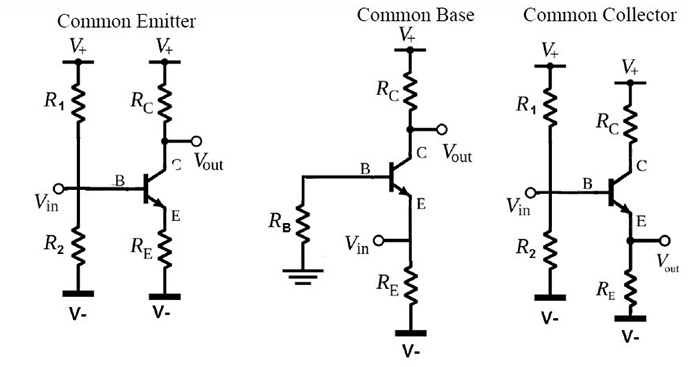

Il existe trois configurations de base d'un transistor bipolaire utilisé pour amplifier un signal et elles sont nommées en fonction de la manière dont les bornes du transistor (émetteur, base et collecteur) sont connectées par rapport à la source du signal et à la charge. Les trois assemblages sont représentés dans la figure ci-dessous :

Nous allons explorer l'analyse d'un composant à trois bornes qui partage de nombreuses applications avec le BJT ou transistor bipolaire, que nous avons déjà étudié. Les dispositifs à effet de champ sont communément appelés FET (Field Effect Transistor) et il en existe deux types principaux :

Nous commencerons notre étude de ces transistors en comparant certaines de leurs similitudes et différences avec les BJT. La principale distinction entre les deux est que le BJT est contrôlé en courant, tandis que le FET est contrôlé en tension. Dans les deux cas, le courant dans le circuit de sortie est régulé par un paramètre du circuit d'entrée, soit le niveau de courant, soit le niveau de tension appliqué.

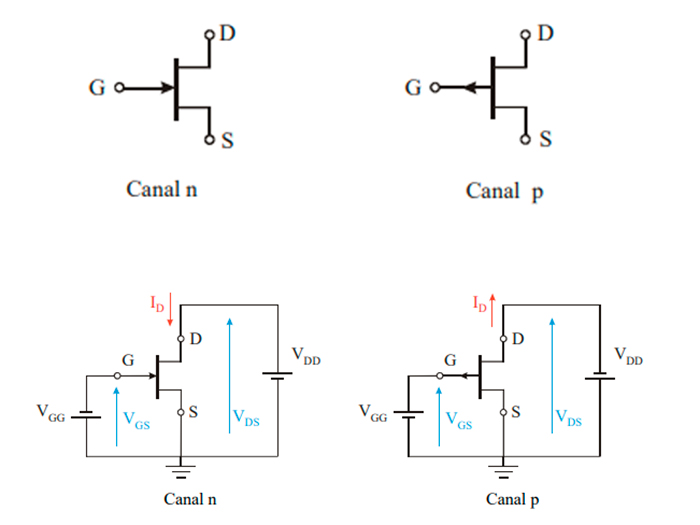

Les FET génèrent un champ électrique qui module la conductivité du chemin de sortie sans nécessiter de contact physique entre le courant contrôlé et la tension de commande. Semblables aux BJT classés en types npn et pnp, les FET se distinguent par leur canal n ou leur canal p.

Une différence clé entre ces types de transistors est que si les BJT sont bipolaires, impliquant la participation des deux types de porteurs (électrons et trous) dans le courant, les FET sont unipolaires, dépendant d'un seul type de porteur : les électrons pour ceux du canal n. et trous pour canal p.

Une caractéristique essentielle des FET est leur impédance d'entrée élevée, qui peut atteindre plusieurs centaines de mégohms, bien supérieure à celle des BJT, qui ont généralement des impédances d'entrée de l'ordre du kiloohm. Cela rend les FET idéaux pour les applications d'amplificateurs.

Cependant, les BJT sont plus sensibles aux changements du signal appliqué, ce qui signifie que pour la même variation de tension appliquée, la variation correspondante du courant de sortie est plus grande dans les BJT que dans les FET. Cela se traduit par des gains de tension alternative généralement plus élevés dans les amplificateurs avec BJT qu'avec les FET.

En général, les FET sont plus stables thermiquement et généralement plus compacts que les BJT, ce qui les rend particulièrement utiles dans les circuits intégrés, notamment les MOSFET.

Un aspect notable des FET est leur capacité à se comporter comme des résistances ou des condensateurs, ce qui permet de créer des circuits utilisant exclusivement des transistors FET.

No contexto dos transistores bipolares (BJTs), observamos que a corrente que flui do coletor para o emissor é diretamente proporcional à corrente que flui da base, permitindo que o BJT regule a corrente. Os BJTs podem lidar com uma grande quantidade de corrente de saída com uma pequena corrente de entrada na base. Por outro lado, no caso dos transistores de efeito de campo de junção (JFETs), a corrente que flui do dreno para a fonte é determinada pela tensão aplicada à sua porta. Portanto, é um dispositivo controlado por tensão.

O JFET é mais eficiente que o BJT e pode realizar todas as funções que um BJT pode realizar. É amplamente utilizado na fabricação de chips CMOS digitais devido à sua eficiência, velocidade, baixo custo e tamanho compacto.

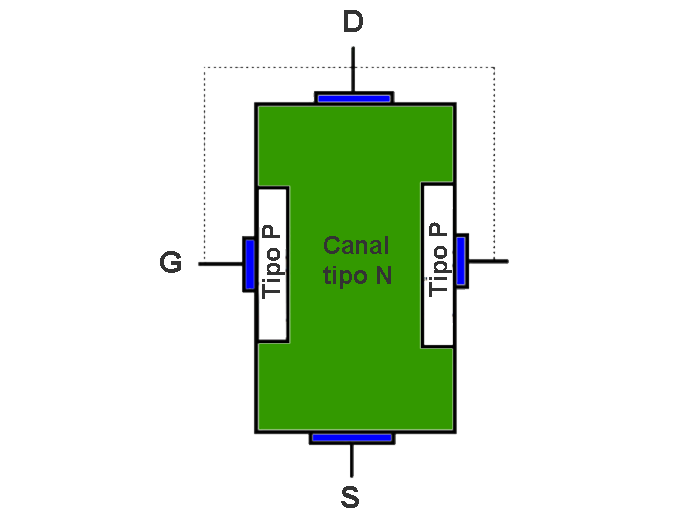

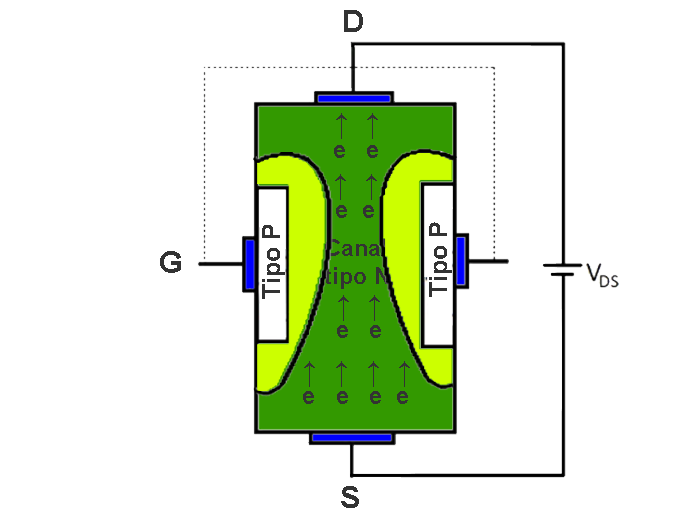

L'illustration ci-dessous représente un transistor JFET à canal N, avec trois bornes : drain, source et grille. Le drain et la source sont connectés aux extrémités du bloc semi-conducteur de type n, permettant au courant de circuler du drain vers la source. Dans ce cas, les deux terminaux de porte sont reliés par une fine ligne pointillée, ce qui signifie que généralement ces appareils ont ces deux terminaux de porte réunis, mais dans certains cas, les deux terminaux de porte sont accessibles indépendamment. Pour réguler ce courant, deux régions de type p sont créées à proximité du canal de type n aux deux extrémités, qui sont connectées en interne pour former la borne de porte du JFET. Ces régions forment deux jonctions p-n, générant une petite région d'appauvrissement. En polarisant ces jonctions, nous pouvons contrôler la largeur de la région d'appauvrissement et donc la quantité de courant circulant du drain vers la source. Cette même structure est inversée dans le JFET à canal P.

|

D (Drain). C'est le terminal par lequel les transporteurs du dispositif (les électrons dans le JFET à canal n et les trous dans le JFET à canal p) S (Source). C'est le terminal par lequel entrent les transporteurs. G (Gate). C'est le terminal à travers lequel est contrôlé le courant des porteurs à travers le canal. |

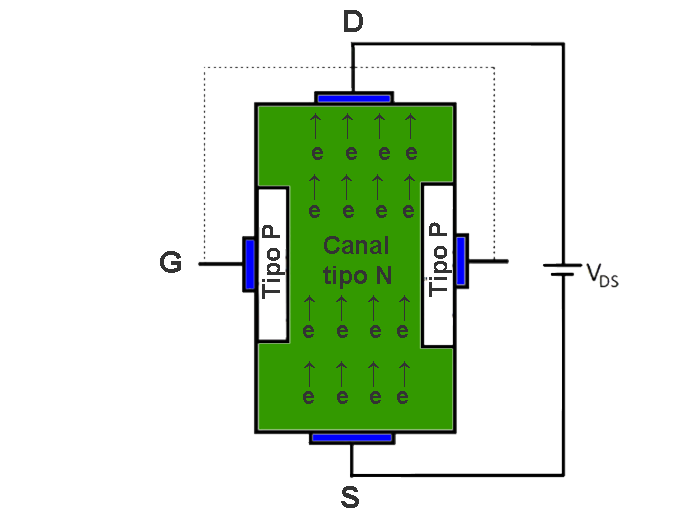

Considérons que pour le JFET à canal N ci-dessus, nous connectons le drain et la source à une alimentation en tension (VDS) et court-circuitons la grille à la source comme indiqué. Un courant commence à circuler du drain vers la source (courant de drain). En appliquant une tension à la grille et à la source, nous pouvons contrôler ce courant.

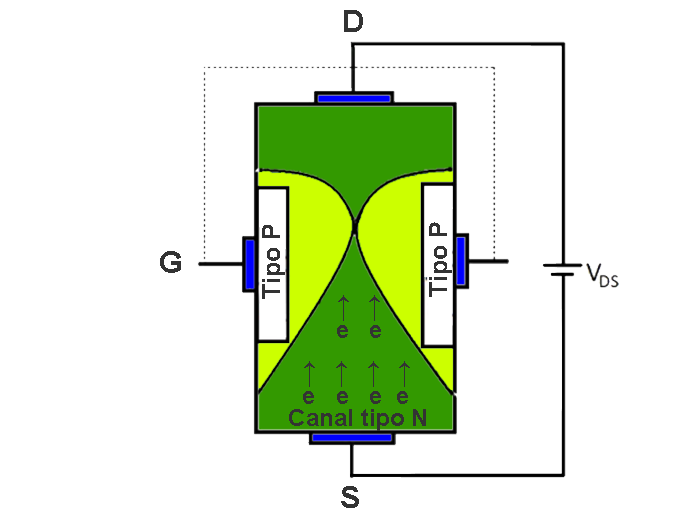

Si nous augmentons encore davantage la tension drain-source, les jonctions pn connaîtront une polarisation inverse plus importante et la région d'appauvrissement s'étendra, comme le montre l'image ci-dessous. Par conséquent, la résistivité du canal va également augmenter. Par conséquent, le courant de drain ne continuera pas à augmenter de manière linéaire.

Nous pouvons voir que la région d’épuisement est plus large côté drain et plus étroite côté source. Cela est dû à la résistivité du bloc de canal n. Lorsqu'une source d'alimentation est connectée au bloc de type N, le courant de drain commence à circuler, créant une chute de tension à ses bornes. Plus la résistance est élevée, plus la chute de tension est importante. Par conséquent, le côté drain devient plus chargé positivement que le côté source. De ce fait, la polarisation des jonctions devient plus importante côté drain.

Si nous continuons à augmenter la tension aux bornes du drain et de la source du JFET, il y aura un point où les deux régions d'appauvrissement se toucheront. Cette condition est connue sous le nom de condition de pincement. La tension entre le drain et la source (VDS) à ce stade est connue sous le nom de tension de pinch-off (VP). À ce stade, aucun courant ne circulera du drain vers la source.

S'il n'y a aucun flux de courant dans le canal. Il n’y aura pas de niveau de tension différent à travers le canal. La région d'épuisement va donc se remodeler et sa largeur sera égale tout autour des jonctions. Ensuite, la chaîne s'ouvrira à nouveau. Cela permettra au courant de drain de circuler à nouveau.

Comme nous l'avons considéré précédemment, il n'y aura aucun courant de drain après le pincement, ce qui n'était pas correct. Il s'agit plutôt du courant maximum (zone de saturation) qui peut circuler du drain à la source. Si nous augmentons encore le VDS, le courant restera constant. Il s'agit du courant maximum à VGS = 0 et VDS > VP et il est connu sous le nom de courant de saturation drain-source (IDSS). Dans le cas du JFET à canal P, ces considérations sont inversées.

Mais lorsque nous appliquons une tension négative entre la grille et la source, la région d'appauvrissement s'élargit même si la tension drain-source est constante. De cette façon, nous pouvons contrôler le courant circulant du drain à la source.

Comme nous le voyons, la seule différence dans le symbole d’un transistor JFET N et d’un transistor P est le sens de la flèche. Entrant pour ceux qui ont le canal N et sortant pour ceux qui ont le canal P.

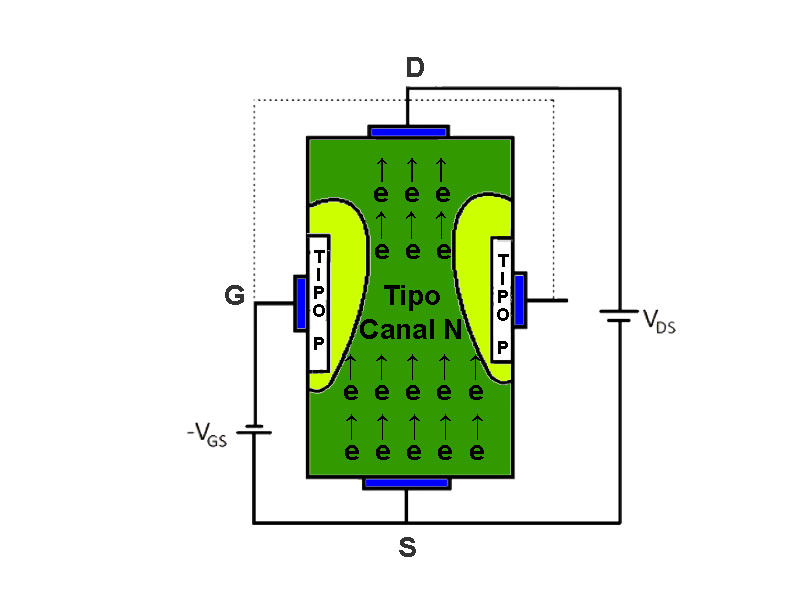

Pour un fonctionnement typique, les transistors à canal N sont polarisés en appliquant une tension positive entre le drain et la source (VDS) et une tension négative entre la grille et la source (VGS). Cela permet au courant de circuler dans la direction du drain vers la source. Pour les JFET à canal P, la polarisation nécessite une tension VDS négative et une tension VGS positive. Cela provoque la circulation du courant dans la direction de la source vers le drain.

| CANAL N | CANAL P |

| VDS positif | VDS négatif |

| VGS négatif | VGS positif |

| ID positif (entrant) | ID négatif (sortant) |

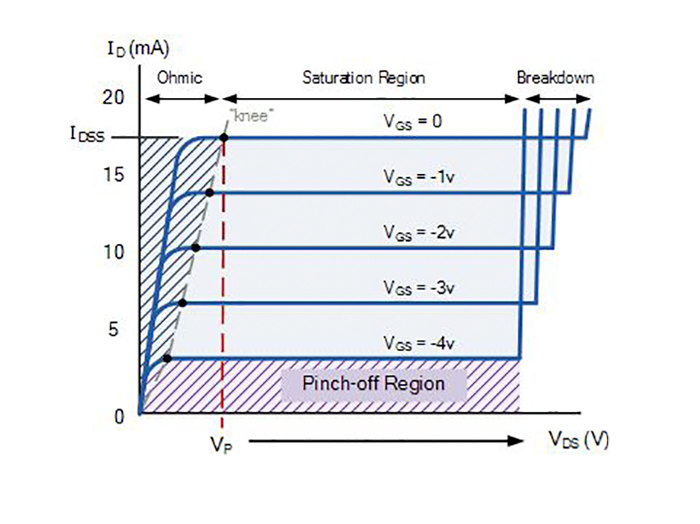

Si l'on combine maintenant dans un même graphique l'impact des deux tensions (VDS et VGS) sur le fonctionnement de l'appareil, on obtient ce que l'on appelle les courbes caractéristiques du transistor JFET.

Les courbes caractéristiques de sortie pour un JFET à canal N sont présentées dans la figure ci-dessous. Dans ces courbes, le courant de drain (ID) est représenté en fonction de la tension drain-source (VDS) pour différentes valeurs de la tension grille-source (VGS).

On note que la valeur de la tension VDS pour laquelle le courant de drain entre en saturation lorsque VGS = 0 est parfois représentée par VP, faisant référence au « throttling » ou au « pincement » qui se produit dans le canal. Il est important de noter que cette tension VP peut être considérée comme d'égale amplitude mais de signe opposé à la tension VGSoff, caractéristique du dispositif.

En revanche, pour les autres valeurs de VGS, la valeur de la tension VDS à laquelle la saturation du courant de drain est atteinte peut être calculée à l'aide de l'expression VDSsat = VGS - VGSoff, où toutes les tensions doivent être considérées avec leur signe respectif. . Autrement dit, plus la tension VGS est négative, plus la saturation sera atteinte rapidement, ce qui signifie que le canal se rétrécira pour des valeurs VDS inférieures, ce qui est logique puisqu'un VGS plus négatif signifie un canal initial plus petit.

Sur cette courbe, on peut identifier quatre zones bien définies :

Dans cette zone du graphique, qui correspond à l'axe horizontal, l'ID actuel est égal à zéro quelle que soit la valeur de VDS. Cela se produit lorsque les valeurs VGS sont inférieures ou égales à VGSoff, indiquant que le canal est complètement fermé.

Ce comportement se produit lorsque les valeurs VDS sont inférieures aux valeurs de saturation, c'est-à-dire lorsque VDS ≤ VGS - VGSoff. Dans cette situation, le canal se rétrécit principalement du côté drain, jusqu’à atteindre un étranglement complet dans VDSsat. Dans cette région, le transistor ressemble à peu près à une résistance variable contrôlée par la tension de grille, notamment pour les faibles valeurs de VDS. À mesure que nous approchons de VDSsat pour chaque valeur de VGS, la linéarité est perdue en raison du rétrécissement du canal à l'approche de la fermeture.

Dans cette zone pour VDS < VDSsat, le JFET se comporte comme une résistance variable avec VGS.

Cette phase se produit lorsque les valeurs VDS sont supérieures à VDSsat. Désormais, l'ID actuel reste constant avec les changements de VDS (l'hypothèse de canal long étant valable) et ne dépend que de la tension VGS appliquée. Dans cette situation, le transistor fonctionne comme une source de courant contrôlée par la tension de grille, VGS.

La relation entre la tension appliquée VGS et le courant ID circulant dans le canal dans cette phase est définie par l'équation suivante :

| ID=IDSS (1- (VGS/vGSoff))2 |

Pour VDS > VDSsat, le JFET agit comme une source de courant contrôlée par VGS.

Lorsqu'une jonction p-n est polarisée en inverse, la zone de charge d'espace augmente. Cependant, cette tension inverse présente une limite, appelée tension de claquage, caractéristique de chaque joint et généralement fournie par le fabricant dans les fiches techniques. Si cette tension de claquage est dépassée, le joint est percé, provoquant la rupture du dispositif.